Durante 30 años, abrir un navegador fue sinónimo de libertad en Internet. Hoy, cada vez más, parece abrir una tumba. La frase suena drástica, pero refleja una realidad que muchos empiezan a reconocer. El semanario The Economist lo advirtió con crudeza al señalar que la inteligencia artificial está matando a la World Wide Web.

No hablamos del fin técnico de Internet, sino de la muerte cultural y funcional de la web abierta tal como la conocimos. El modelo económico que la sostuvo durante dos décadas – contenido gratuito a cambio de tráfico direccionado desde buscadores y monetizado con publicidad – se está desmoronando. Herramientas de IA como ChatGPT ahora responden las preguntas directamente en lugar de enviar visitantes a las páginas web, provocando caídas de tráfico dramáticas.

En otras palabras, aquella «gran alianza» que impulsó la web libre está rota, y con ella se apaga la era de aquella Internet abierta y vibrante.

¿Cómo llegamos hasta acá?

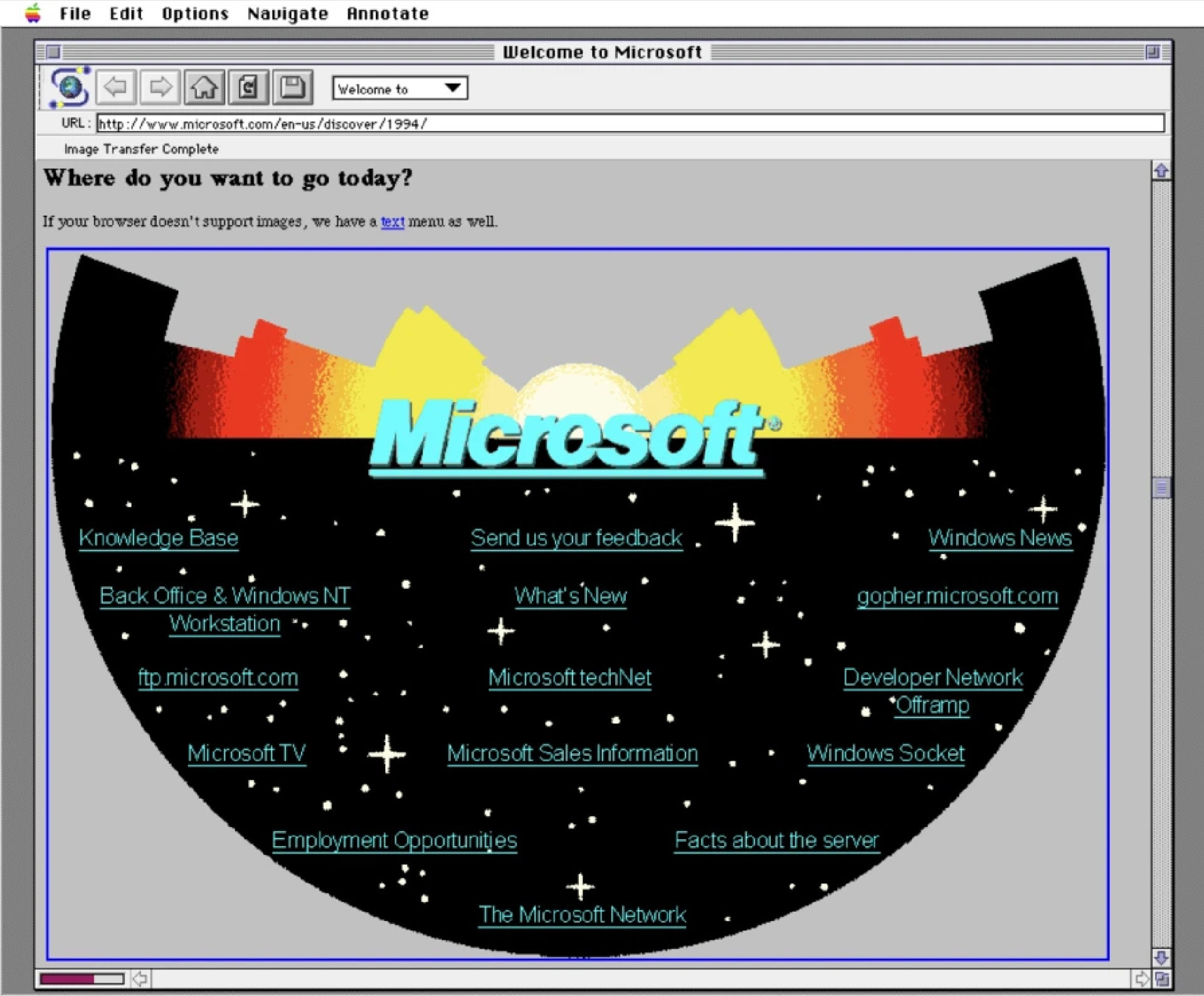

La web prosperó bajo un pacto tácito: los sitios ofrecían contenido libremente, los motores de búsqueda lo indexaban, y los usuarios eran dirigidos a esos sitios para consumir la información, generando visitas que luego se convertían en ingresos publicitarios. Este ecosistema alimentó a miles de medios digitales, blogs independientes (como Tecnovortex), foros y comunidades en línea que florecieron durante los años 2000. Hubo una época – podemos ubicarla alrededor de 2005, el “prime” de la web 2.0 – en que navegar de un sitio a otro era la forma principal de descubrir información y participar en comunidades digitales.

Sin embargo, con el tiempo algo se fue torciendo. El contenido empezó a optimizarse más para algoritmos que para personas: SEO agresivo, titulares cebo de clics (clicbait), listas interminables y artículos pensados solo para posicionar. En la frenética carrera por ganar clics, likes e interacción, terminamos llenando Internet de basura entretenida pero vacía. Lo que solía ser un espacio de blogs personales sinceros y foros especializados dio paso a un océano de contenidos genéricos diseñados únicamente para atraer tráfico. La web abierta ya venía sufriendo una erosión de calidad: abundan páginas repletas de contenido superficial creado para farmear visitas, en detrimento de la autenticidad y la profundidad.

Entonces llegó el golpe final. La explosiva llegada de las IA conversacionales ha quebrado por completo la cadena de valor de este ecosistema. Hoy los usuarios muchas veces ya ni siquiera hacen clic en los resultados: obtienen respuestas inmediatas y sintetizadas por la IA, ya sea en la propia página de resultados de Google o mediante asistentes tipo ChatGPT. En términos simples, Google ya no te lleva a los sitios; te los resume. Y en ese proceso, la web abierta se convierte en un simple dataset en segundo plano, un repositorio de información del cual las IA se alimentan sin necesidad de mostrarte la fuente. No lo decimos solo nosotros: editores como Neil Vogel (CEO de Dotdash Meredith) afirman que Google «rompió el acuerdo» original y ahora «nos está robando nuestro contenido para competir con nosotros». La consecuencia inmediata es que muchas páginas han visto desplomarse sus visitas e ingresos, poniendo en jaque la viabilidad de medios y comunidades en toda la web.

La IA como intermediario total

Los grandes modelos de lenguaje (LLM) actúan como nuevos intermediarios absolutos de la información en Internet. A diferencia de un usuario humano, estas IA no “navegan” la web ni participan en ella: simplemente consumen enormes cantidades de contenido durante su entrenamiento y luego regurgitan conocimiento sintetizado en forma de respuesta. En vez de un internauta explorando enlaces y leyendo páginas, tenemos algoritmos que absorben el contenido de millones de sitios para luego devolver al usuario una respuesta puntual, saltándose por completo la visita a las fuentes. Esto rompe el ciclo clásico de la web abierta: el usuario obtiene la información que busca, pero nunca llega a la página del creador original, cortando de raíz el tráfico y la retroalimentación que mantenía vivo al ecosistema. En este escenario, “las páginas web pierden visitas, ingresos y relevancia” porque la IA digiere todo por adelantado. El contenido deja de ser un destino y pasa a ser una fuente anónima de datos para los modelos, invisible para el consumidor final.

Las métricas confirman esta tendencia alarmante. Según varios estudios, en el último año el tráfico global proveniente de búsquedas cayó alrededor de 15% a nivel mundial, precisamente a medida que más usuarios adoptan herramientas como ChatGPT. Las categorías más golpeadas son aquellas típicamente consultadas vía Google: sitios de ciencia y educación perdieron un 10% de sus visitantes, los sitios de referencia un 15%, y las páginas de salud sufrieron caídas de hasta 31%. Google admite que, desde que incorporó resúmenes de IA en sus resultados, el porcentaje de búsquedas de noticias que no generan ningún clic saltó del 56% al 69% – es decir, 7 de cada 10 personas que busca algo ya no siente necesidad de visitar ningún enlace. Menos ojos humanos en las webs significa menos impresiones publicitarias, menos suscriptores potenciales y menos colaboradores en comunidades abiertas.

Las consecuencias ya se hacen sentir. «La naturaleza de Internet ha cambiado por completo», resume el CEO de Stack Overflow, Prashanth Chandrasekar, señalando que la IA está «básicamente ahogando el tráfico» hacia la mayoría de los sitios de contenido. Con menos visitantes reales, incluso comunidades famosas flaquean: en Stack Overflow disminuyen las preguntas nuevas, y Wikipedia advierte que los resúmenes automáticos sin atribución “bloquean las vías de acceso” de las personas a su sitio, impidiendo que descubran artículos o se animen a editarlos. En otras palabras, la IA se ha interpuesto entre el público y la web, devorando la atención y estrangulando el flujo de usuarios que antes mantenía la diversidad de la red. La web abierta se está volviendo una suerte de «API muerta»: sigue proveyendo datos, pero ya casi nadie interactúa con ella directamente.

El futurode Internet: la web como sistema legacy

Si nada cambia, el destino de la web abierta podría ser volverse un sistema legacy en toda regla. Es decir, pasaría a ser la «Internet vieja», una reliquia que sigue ahí por compatibilidad pero a la que pocos prestan atención. Podemos trazar un paralelismo con lo que fueron los BBS, Usenet o el chat IRC: tecnologías pioneras de la red que siguen funcionando, pero de las que hoy casi solo hablan los nostálgicos. Algunos analistas ya especulan que la web abierta podría terminar igual, «técnicamente operativa, pero convertida en un páramo de espacios desiertos o infestados de spam, mientras el grueso de la discusión y el comercio se traslada a otro lado». No es difícil imaginar este escenario: un montón de sitios abandonados, foros fantasmas y blogs sin lectores, mientras las conversaciones vivas ocurren en plataformas cerradas o servicios de IA.

Las nuevas generaciones quizás ni siquiera lleguen a conocer la web como la entendemos. Para muchos jóvenes, hoy «buscar en Internet» equivale a scrollear TikTok o consultarle a ChatGPT, no a teclear una URL en el navegador. Google ha reconocido que cerca del 40% de los Gen Z prefieren usar TikTok o Instagram para buscar recomendaciones en lugar de Google Search. Y si ya recurren a redes sociales en vez de páginas web, ¿qué pasará cuando los asistentes de IA estén plenamente integrados en sus vidas? Es muy posible que las próximas generaciones nunca visiten directamente un sitio web para informarse o resolver dudas y deleguen esa tarea a agentes de IA. Teclear una dirección web a mano podría sonarles tan arcaico como para nosotros conectar un módem de 56 kbps y oír su ruido de fax. La web abierta persistiría, sí, pero más que nada como un legado obsoleto: un sistema que ahí queda, funcionando en segundo plano (y necesitado por las propias IA para alimentarse de datos), pero que nadie quiere mantener ni usar activamente. En términos de la industria, un legacy system: útil solo porque no ha sido reemplazado del todo, pero condenado a la marginalidad.

¿Renacimiento de la vieja Internet o reemplazo?

Frente a este panorama, cabe preguntarse si la web abierta tendrá un renacimiento o si será simplemente reemplazada por completo. Hay quienes confían en que veremos una auténtica «Web 3.0” emerger de esta crisis (no aquella versión bastante insulsa de NFTs, sino una web reinventada con nuevos paradigmas de valor). En tal escenario optimista, la IA y la web podrían coexistir de forma más justa. Se exploran ya mecanismos para ello: por ejemplo, empresas como Cloudflare están ofreciendo medios para que los sitios web cobren por el acceso de bots de IA (estableciendo “peajes” o tarifas por rastreo). Startups como Tollbit han procesado millones de microtransacciones cobrando centavos a los crawlers de IA por cada contenido extraído, incentivando así que se genere menos spam y más información original. Otras iniciativas, como ProRata, proponen repartir los ingresos publicitarios de las respuestas generadas por IA entre los sitios que aportaron la información, mediante acuerdos de licencia colectivos. En paralelo, organismos como la W3C (World Wide Web Consortium) investigan nuevas normas y protocolos: por ejemplo, estándares para incorporar una etiqueta o conciencia sobre el uso de contenido por parte de las IA dentro de la infraestructura misma de la web. También se habla de IA descentralizada, con modelos abiertos y comunitarios, que podrían evitar que todo el conocimiento en línea quede mediado por un puñado de corporaciones. Quizá en unos años contemos con agentes inteligentes operando bajo reglas transparentes, negociando con los sitios el acceso a datos a cambio de micropagos en tiempo real, manteniendo vivo un ecosistema donde creadores y máquinas coexistan en equilibrio. Este sería el escenario de un renacimiento: la web adaptándose y reinventándose para seguir siendo relevante en la era de la IA.

Por otro lado, existe una visión más cínica (pero no menos plausible): que tal vez la web libre ya dio de sí lo que podía dar. Según esta perspectiva, estamos siendo testigos no de una metamorfosis, sino del ocaso de un ciclo histórico. La era de la web abierta habría cumplido su misión de democratizar el acceso a la información durante unos años, pero ahora estaría siendo eclipsada por servicios cerrados y entornos controlados. En vez de un renacimiento, habría un relevo: pasamos a la era de los jardines amurallados y los asistentes conversacionales como interfaz principal. Los feeds personalizados y los chatbots inteligentes se convertirían en las nuevas «portadas» de Internet, relegando a la web tradicional al subsuelo. Y es posible que, incluso si quisiéramos revivir aquel viejo ecosistema, ya sea demasiado tarde. The Economist insinuó que este cambio podría ser irreversible: el modelo de la web tradicional muere, y solo sobrevivirán aquellos creadores y plataformas que logren adaptarse al nuevo flujo de información controlado por las IA. En vez de una web 3.0 abierta, tendríamos un nuevo paradigma completamente distinto, donde la libertad y diversidad original de la web quedarían diluidas bajo capas de algoritmos propietarios.

¿Qué camino prevalecerá? Es difícil saberlo. Quizá asistamos a intentos de resurrección de la web abierta mediante innovaciones técnicas y legales, o tal vez veremos consolidarse un reemplazo definitivo. Tal vez la web libre logre reinventarse y encontrar un nicho en convivencia con las IA… o quizás quede relegada a los libros de historia de la tecnología.

Quizá el sueño de la web libre no muera del todo. Quizá solo quede en la memoria, como una partición FAT32 perdida entre los discos de la historia digital.

Tremendo análisis, me sorprendió en su momento cuando ví que la gente empezó a buscar productos y servicios a través de Instagram y ahora TikTok, ahora con la IA me preguntó cómo será el nuevo SEO.

Gracias por estos contenidos.

Yo sigo entrando a tu página, a Gizmodo, a Xataka, y me da poca cosa las IA todavía. Será que estoy pisando los 40 añitos. Y ya ni bola le doy a lo nuevo.

Siempre sere de la idea de que el SEO mato internet y la IA lo salvo.

TKM, te sigo desde la latita.

Este tipo de comentarios es el que nos hace seguir adelante.

Te mando un fuerte abrazo.