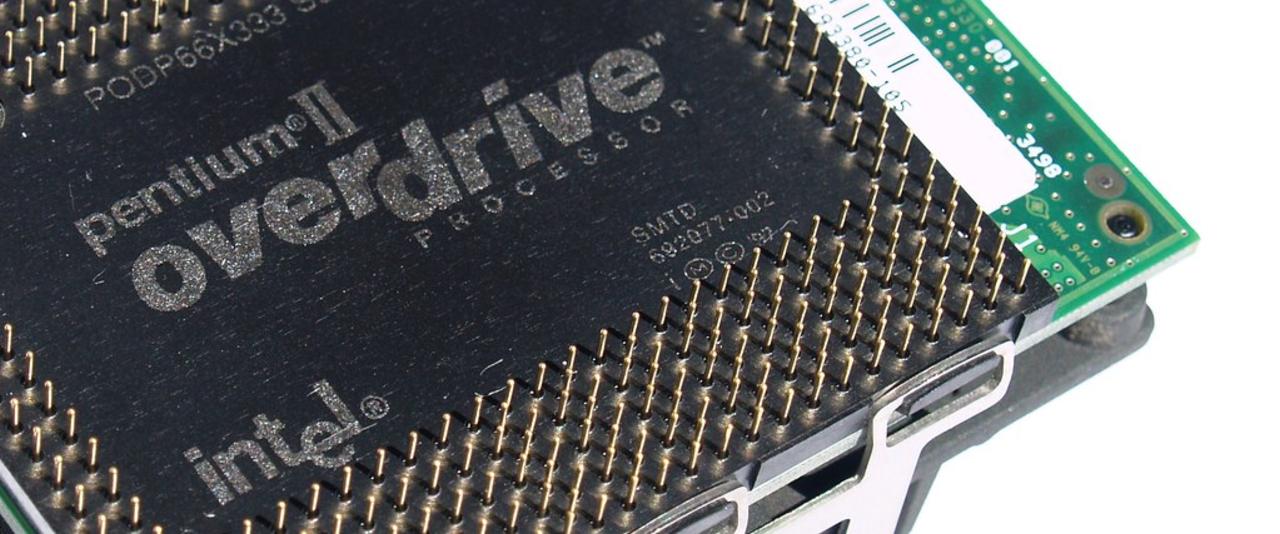

Vamos terminando este año y nos ponemos un poco nostálgicos. Me explico: existió una época en que el overclocking era sinónimo de ingenio, rebeldía y diversión artesanal. A fines de los 90 y comienzos de los 2000, los entusiastas de PC descubrieron que podían tomar CPUs modestas y hacerlas rendir como modelos mucho más caros. ¿El caso más legendario? El Intel Celeron 300A (1998): un humilde chip de 300 MHz que, con solo ajustar el FSB de 66 a 100 MHz, saltaba mágicamente a 450 MHz y se ponía a la par de un Pentium II 450 que costaba el triple. Para muchos fue casi un acto de rebelión: pagar centavos por un 300A y hacerlo correr como un PII «tope de gama» era nuestra forma de «ganarle al sistema». En Argentina, donde los componentes siempre dolieron al bolsillo, este tipo de jugadas se sentían como la victoria del pibe entusiasta sobre las grandes marcas.

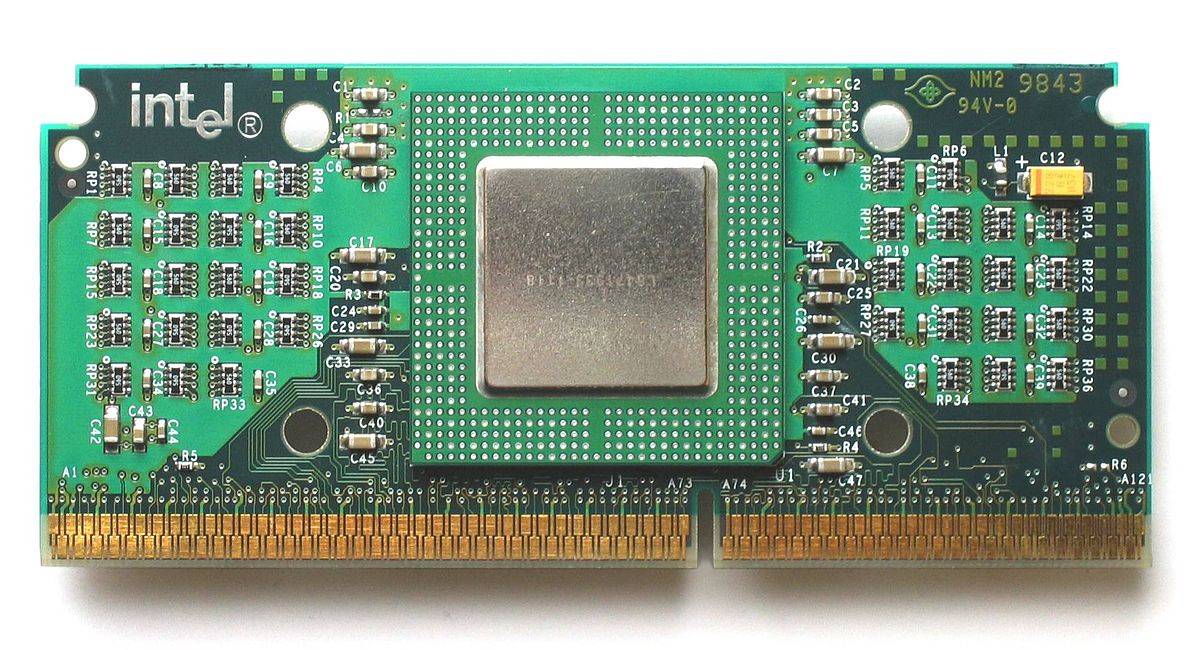

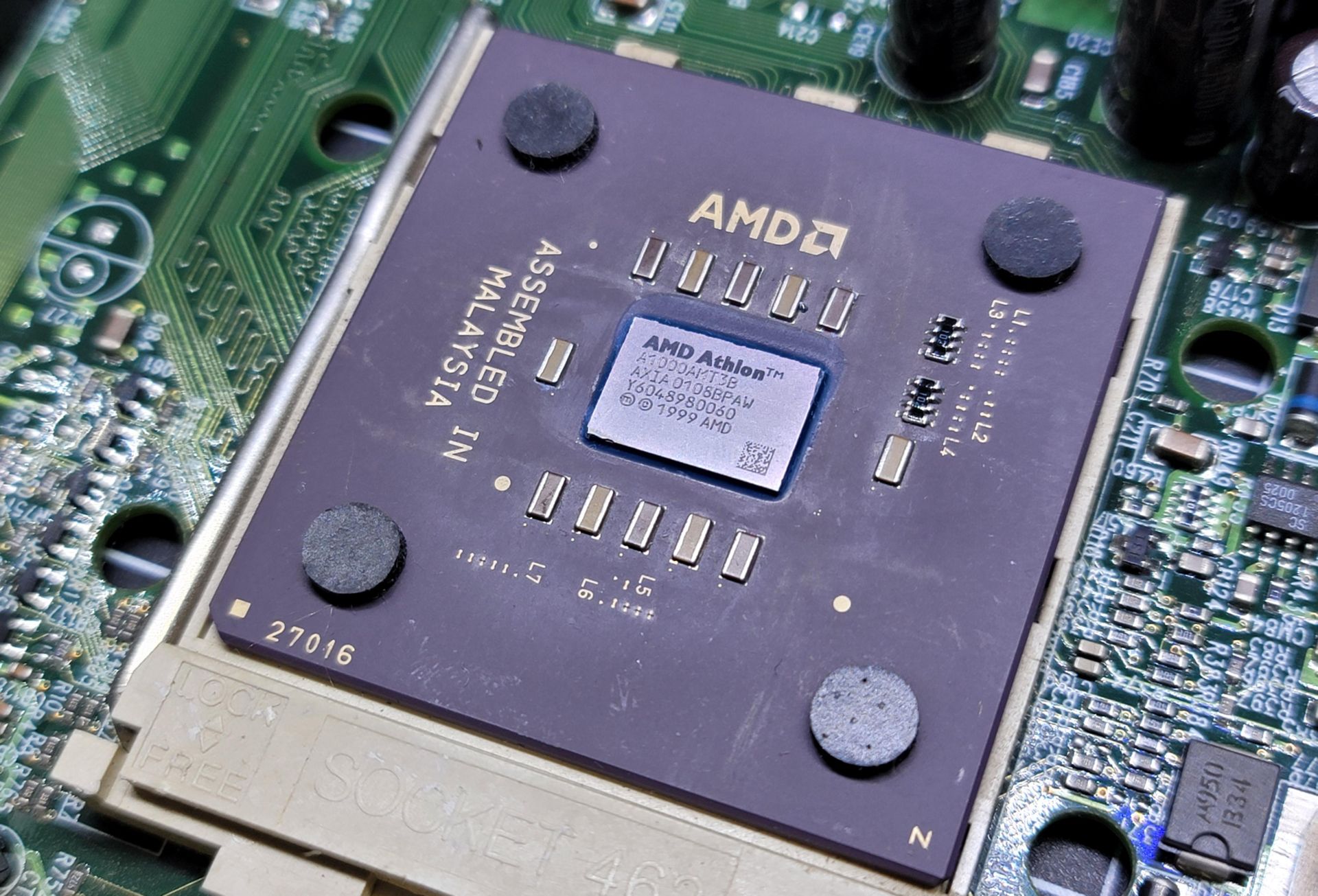

Después vinieron otros hitos inolvidables. Los AMD Athlon «Thunderbird» a principios de los 2000 permitían overclocks de 200 o 300 MHz con buen enfriamiento (y un lápiz para desbloquear multiplicadores, old school total). Ni hablar del Athlon XP 2500+ Barton (2003), un CPU que muchos recordarán: corría a 1.83 GHz de fábrica, pero bastaba con subir el bus de 166 a 200 MHz para que funcionara a ~2.2 GHz, equivalente a un costoso Athlon XP 3200+ casi sin despeinarse. Los «pibes cancheros» del hardware en 2004 tenían un Barton 2500+ llevado a 3200+ y se sentían dioses de la PC. Intel no se quedó afuera de la fiesta: el Pentium III (Coppermine) también tuvo lo suyo; modelos como el 550 MHz a veces llegaban a 733 MHz o más con enfriamiento decente. Y en la era pre-Core, algunos locos adaptaron los Pentium M de laptops al escritorio (mediante mods y placas especiales, como el kit Asus CT-479) para lograr frecuencias altísimas con ese chip móvil eficiente. Era una especie de «Frankestein» glorioso: un Pentium M Dothan de 1.6 GHz podía correr a más de 2.4 GHz en desktop y rendir mejor que los Pentium 4 tragones de la época.

La cúspide llegó a mediados de los 2000 con la generación Intel Core 2 Duo (Conroe). CPUs como el Core 2 Duo E6300 (1.86 GHz) eran baratos y ¡vaya si escalaban! Con una buena placa P965/P35 y RAM rápida, un E6300 podía rozar el 100% de overclock estable, llegando cerca de 3.6–3.8 GHz. De un plumazo superabas al carísimo Core 2 Extreme X6800 de $999 USD y su 2.93 GHz. Ninguna empresa iba a volver a dejar tanto margen sobre la mesa, pero en ese momento vivimos un sueño: comprabas gama media y, con maña, la convertías en entusiasta. AMD también tuvo joyitas como los Athlon 64 Socket 939 y los Opteron 144/146, o el Phenom II X2 «que desbloqueaba» a X4. Era una época dorada: FSB por las nubes, multiplicadores desbloqueados (o desbloqueables con trucos), voltajes subiendo a niveles de miedo, mods físicos (¿alguien dijo «puente L1 con lápiz de grafito» en los Athlon XP?) y soluciones de enfriamiento caseras que iban desde ventiladores de 12 cm ruidosos hasta refrigeración líquida «de pecera» hecha en casa. Los foros hervían con comunidades como Overclock.net, XtremeSystems, HardOCP y, por estas pampas, sitios como MáximoPC donde compartíamos logros, fracasos y fotos de ese disipador del tamaño de un ladrillo con el que intentábamos domar a un Prescott calienta-hornos.

Overclockear no era solo obtener FPS gratis: era un deporte. Había competencia por el benchmark más alto en 3DMark o SuperPI, surgieron hasta «ligas» de overclocking extremo donde la gente empezó a usar refrigeración con nitrógeno líquido (LN2) o helio para exprimir cada MHz. Nombres legendarios como Macci, Kingpin o Team Japan batían récords mundiales llevando chips a frecuencias ridículas solo para clavar su nick en lo más alto de HWBOT. La gran mayoría de mortales no llegábamos a esos extremos, pero entendíamos la pasión: el overclock era la filosofía del hacker de hardware, el «yo tuneo mi PC» como quien modifica su auto en el garage. Era aprender haciendo: quemar uno que otro componente en el proceso (despedite de ese Duron si te pasaste de voltaje), pero celebrar cada pequeño éxito como una épica personal.

¿Que nos pasó? Motivos técnicos de la muerte del overclock

Si uno mira este año que se termina y un poquito para atrás, el panorama es otro planeta. Las CPUs modernas vienen tan al límite de fábrica que apenas hay margen para rascar. Enumeremos las razones técnicas clave de esta «muerte» del overclock manual:

- Binning agresivo por los fabricantes: Hoy Intel y AMD exprimen sus silicios al máximo antes de venderlos. Aquella idea de «CPU barata convertida en joya» prácticamente desapareció porque cada chip se clasifica y se vende ya casi en su límite seguro. Un ejemplo contundente: la empresa Silicon Lottery (famosa por vender CPUs pre-seleccionados para buen overclock) cerró en 2021, al admitir que el escaso headroom de los chips modernos hizo inviable su negocio. Dicho en criollo: ya no quedan esas joyitas ocultas; si un chip puede llegar a 5 GHz estable, probablemente Intel te lo venda como un modelo de 5 GHz y no como uno de 4 GHz «regalable».

- Boost automático y telemetría avanzada: Las CPUs actuales incluyen tecnologías de auto-aceleración muy sofisticadas. Intel tiene Turbo Boost 2.0/3.0, Thermal Velocity Boost, etc., y AMD hizo magia con Precision Boost 2, XFR (eXtended Frequency Range) y Precision Boost Overdrive (PBO). En esencia, el propio procesador monitorea en tiempo real temperatura, consumo y cargas de trabajo, y se overclockea solo dentro de límites seguros. Ya en 2019, AMD explicaba que PBO jamás excede las frecuencias máximas anunciadas; lo que hace es permitir que la CPU mantenga esos boosts más tiempo si la temperatura y energía lo permiten. Cada vez que haya espacio térmico o eléctrico, el chip lo usa al instante, ajustando frecuencias cada 1ms de forma oportunista. El resultado: tu CPU ya viene «tan overclockeada como puede» de fábrica. Cualquier intento manual muchas veces no mejora gran cosa, porque el algoritmo interno ya exprime casi todo el jugo disponible. Como dijo un analista, en términos optimistas esto significa que el procesador se auto-pushnea de forma más sensible y eficiente que lo que lograría un humano. La versión pesimista: el silicio manda, vos mirás y nada más.

- Curvas de voltaje-frecuencia optimizadas dinámicamente (incluso con IA): Relacionado con lo anterior, los fabricantes integraron mecanismos para afinar el voltaje en cada estado boost. Por ejemplo, placas madre modernas traen funciones de «AI Overclocking» o Intel Adaptive Voltage que ajustan la curva voltaje/frecuencia según el propio silicio y la calidad de tu cooling. Básicamente, una mini «IA» calibrando el chip en tiempo real mejor de lo que tus pruebas a mano podrían. Incluso hay tecnologías como Intel BCLK Aware Adaptive Voltage que adaptan automáticamente la curva de voltaje cuando tocas el base clock, para evitar inestabilidad. Es decir, la electrónica ahora toma decisiones que antes requerían al overclocker probando voltaje a voltaje. El romanticismo del trial & error humano pierde frente a la consistencia de un algoritmo entrenado.

- Límites térmicos y de consumo extremadamente precisos: Las CPUs modernas operan pegadas a sus límites térmicos diseñados. Un Ryzen 9 7950X, por ejemplo, está hecho para trabajar rondando los 95 °C bajo carga máxima sin problema – es feature, no bug, como aclaró AMD. A mayor temperatura disponible (si tu cooler lo mantiene bajo 95°, por ejemplo), el chip automáticamente sube más su frecuencia hasta volver a acercarse a ese tope. Intel por su lado exprime el consumo: un Core i9 moderno se manda tranquilamente más de 250 W en stock si la motherboard lo deja, ya alcanzando límites eléctricos de silicio. Ya no hay «margen seguro adicional»; se usa todo desde el arranque. Cualquier overclock manual muchas veces solo te lleva de 95 °C a 100 °C, o de 250 W a 300 W, a cambio de unos pocos MHz. No es negocio… ni para el usuario ni para el chip, que puede degradarse rápido así.

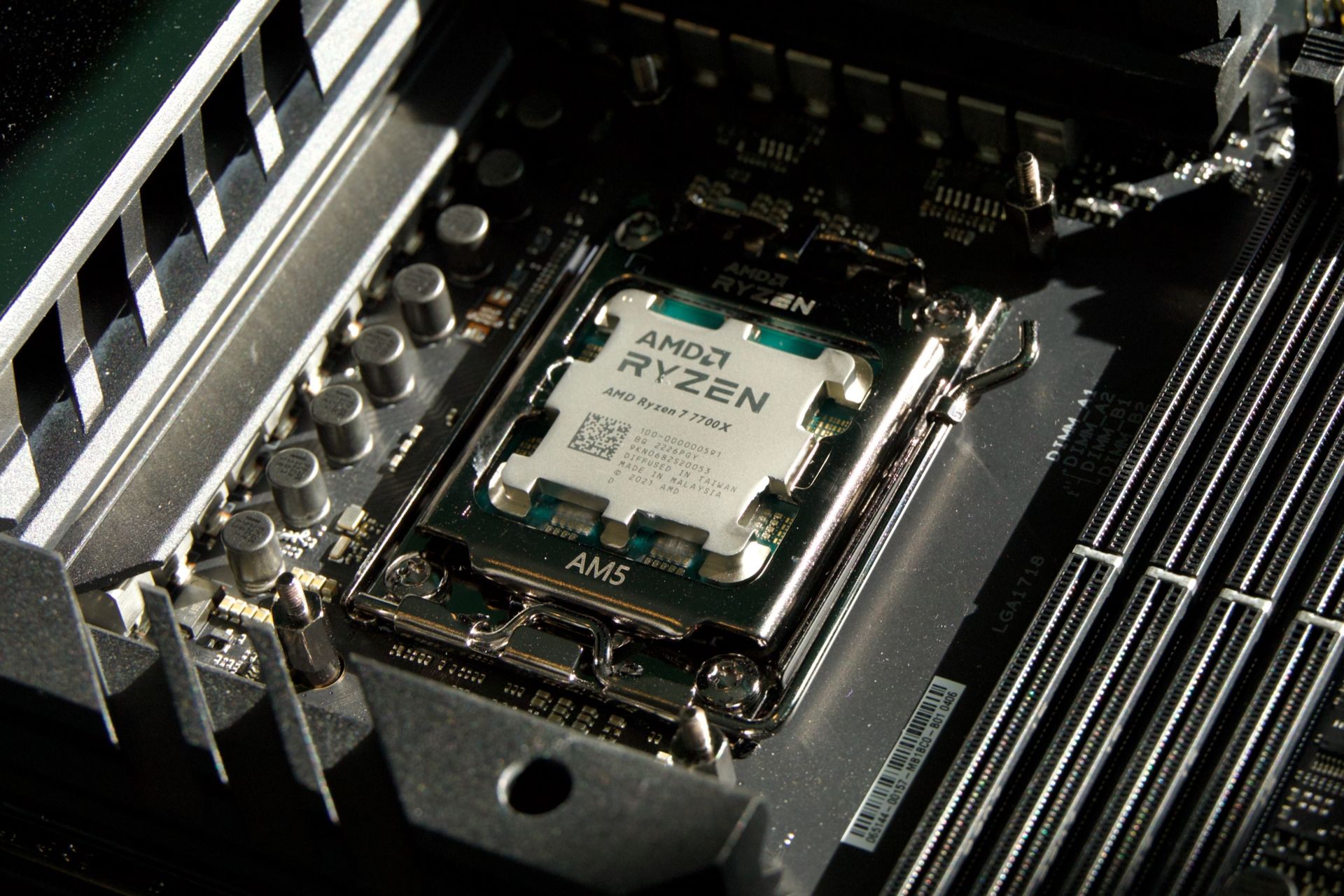

- El fin del multiplicador libre en modelos populares: Intel hace años segmenta su línea en «K» desbloqueados para entusiastas y el resto bloqueados. Pero AMD solía ser más amigable: todas las CPUs Ryzen de 2017-2022 venían desbloqueadas para jugar, excepto las APUs de bajo costo. Sin embargo, con la llegada de la tecnología 3D V-Cache, AMD cambió de postura. Su aclamado Ryzen 7 5800X3D (2022) fue el primer Ryzen moderno en venir completamente bloqueado para overclock, por motivos de voltaje/temperatura. Y repitieron la jugada en la serie Ryzen 7000X3D (2023): modelos como el 7800X3D ya no permiten ajustar multiplicador ni voltajes manualmente, solo habilitan PBO y curve optimizer ligero. Esto tomó por sorpresa a algunos entusiastas: por primera vez en mucho tiempo, AMD te daba un producto gamer top y te decía «no toques nada, déjalo como está». Toda una señal de los tiempos.

- Arquitecturas especializadas intolerantes al overclock: El caso de la 3D V-Cache de AMD es emblemático. Esta caché adicional apilada encima del chip es muy sensible a temperatura y voltaje. AMD tuvo que establecer un límite estricto de ~1.3 V de VSoC y deshabilitar cualquier incremento manual para no freírla. De hecho, a pocos meses de lanzado el 7950X3D/7800X3D, surgieron reportes de chips quemados físicamente por exceso de voltaje en placas madre que no controlaban bien el VSoC con memorias EXPO. La respuesta fue drástica: nuevos BIOS limitaron de fábrica el SoC a 1.3 V y quitaron opciones de sobrevoltaje para proteger estos Ryzen. Traducido: el hardware actual a veces no tolera un overclock significativo – literalmente puede morir en el intento. Otras tecnologías, como los GPUs con stacked dies o memorias GDDR6X al filo de temperatura, también vienen tan al límite que cualquier apretar de tuerca extra las pone en zona de peligro.

Resumiendo, desde el punto de vista técnico, el overclocking manual murió porque las empresas ya no dejan «sobras de rendimiento» en la mesa. La guerra Intel vs AMD por el liderazgo hizo que ambos expriman cada MHz que el silicio puede dar de forma fiable. Un Ryzen 7000 a 5.0 GHz o un Intel a 5.5+ GHz ya salen de caja casi al tope de lo que ese chip puede con voltaje stock. Antes, en cambio, un Core 2 Duo de 1.8 GHz realmente tenía quizás 3.0+ GHz de potencial oculto porque el fabricante conservador no se arriesgaba a venderlo tan al límite. Hoy el mercado demanda estirar todo: si un chip logra 5.8 GHz en un golden sample, Intel te lo vende como 13900KS; si AMD consigue 5.0 GHz con 3D V-Cache sin explotar, te lo entrega así y bloquea todo para que no pases de ahí.

El Ryzen 7 7800X3D: epitafio del overclock tradicional

Si tuviéramos que elegir un «CPU símbolo» de esta nueva era, probablemente sea el Ryzen 7 7800X3D. Lanzado en 2023, este procesador de 8 núcleos con 3D V-Cache se ganó el corazón de los gamers por su rendimiento excepcional en juegos y eficiencia energética. Pero para los viejos overclockers fue también un balde de agua fría: AMD lo vendió con todo su potencial ya exprimido y virtualmente candado para tweaks.

Oficialmente, el 7800X3D no soporta overclock de frecuencia ni ajustes de multiplicador. AMD limitó su Boost máximo alrededor de 5.0-5.05 GHz y dijo «así se queda». Solo permite pequeñas modificaciones mediante PBO2 (que en estos chips básicamente sirve para undervolt/curve optimizer, no para subir clocks). ¿La razón? La mencionada 3D V-Cache: añadirle ~64MB de caché L3 extra encima hizo que la tolerancia a voltajes altos se redujera enormemente. AMD estableció que más de ~1.1 V en los cores con cache apilada puede dañarlos a largo plazo, así que optaron por cuidarlo. En cristiano: te entregan el 7800X3D ya en su punto ideal de eficiencia y rendimiento, y no quieren que lo fuerces más.

Alguno dirá: «Bueno, pero siempre se puede intentar.» Y claro que entusiastas lo intentaron. Overclockers profesionales como SkatterBencher lograron llevar un 7800X3D hasta ~5.4 GHz en un núcleo usando trucos exóticos: placas madre con generadores de reloj externos, PBO elevado y hasta voltajes un pelín por encima de stock. ¿El resultado? Apenas un +7-10% de frecuencia respecto al stock. Y ojo, con riesgo: incluso el propio SkatterBencher admitió que queda por ver cuánto degrada ese chip al meterle voltaje extra para sostener 5.4 GHz. De hecho, el pobre héroe 7800X3D a 5.4 GHz rendía similar a un Ryzen 7 7700X (que llega a 5.4 de fábrica) pero consumiendo mucho más y con la única ventaja de la cache extra. No vale la pena. Es el ejemplo perfecto del fin de una era: antes lograbas 50% más performance con overclock; hoy arriesgas la vida del CPU por 5-10% que en uso real ni se siente.

AMD lo deja claro incluso en sus guías: el 7800X3D está pensado para usarse tal cual viene. Cualquier «manipulación intencional» de voltajes o clocks puede dañar el procesador, la placa y el zócalo, advirtieron junto a los fabricantes. Y tras los incidentes de chips quemados, los BIOS nuevos directamente impiden exceder los 1.3 V de VSoC. En resumen, este Ryzen es anti-overclock por excelencia. Irónicamente, es uno de los mejores CPU gaming de la historia, pero precisamente porque AMD ya hizo internamente todo el tuning necesario para que ande perfecto sin que el usuario toque nada.

Para los viejos guardienes del overclock, algo así se siente casi sacrílego. ¿Un CPU de la serie «X» de AMD, con apellido 3D (tope tecnológico), que no puedo overclockear? ¡Inconcebible hubiera sido en 2005! Pero acá estamos. Y la realidad es que con 7800X3D no hace falta overclockear: rinde hermoso out-of-the-box, caliente mucho menos que un Core i9 rival, y encima es eficiente. Es como esos autos deportivos modernos que vienen con la electrónica tan afinada de fábrica que al mecánico tunero ya no le quedan tornillos que ajustar.

Old world vs New world: antes taller de tuning, hoy caja sellada

Comparemos la cultura del PC entuasiasta de antaño con la actual. Antes, armar una PC potente implicaba elegir cuidadosamente componentes con miras al overclock. Uno compraba, por ejemplo, un Celeron barato o un Athlon XP 2500+ sabiendo que con suerte se transformaría en su hermano mayor de gama alta. Se invertía en una buena motherboard «de overclock» (esas Abit, DFI LanParty o Epox, llenas de jumpers y opciones BIOS secretas), memorias con chips «Samsung TCCD» o «Micron D9» famosas por tolerar altas frecuencias, y un buen cooler (quizá un cooler Titan de 800 gramos de cobre, o el famoso Thermalright SP-94 que parecía un disipador de torre Eiffel en miniatura). Luego venía el arte en sí: horas en el BIOS subiendo el FSB de a poquito, probando multiplicadores, voltage modding si hacía falta (muchas veces implicaba soldar o pintar la placa), todo para encontrar ese sweet spot donde la PC volaba 30% más rápido sin explotar.

Había un sentido de comunidad y aventura. ¿Quién no pasó noches en foros buscando la configuración mágica? Guías de usuarios sobre cómo llevar un Opteron 144 de 1.8 a 2.8 GHz, o cómo desbloquear las cuatro pipelines ocultas de cierta placa de video Radeon 9500 para convertirla en 9700… Era exploración pura. Y claro, a veces la pifiábamos y venía el castigo: BIOS corruptas (¡a hacer hot flash con otra placa!), memorias quemadas por pasarnos de voltaje, fuentes genéricas que literalmente hacían pop. Pero todo eso forjó una cultura: el PC modder entusiasta, mitad científico loco, mitad gamer ahorrativo.

¿Y hoy? Hoy el perfil del gamer entusiasta promedio es distinto. Muchos compran CPUs tope ya con la expectativa de usarlos stock o con el PBO activado y listo. Las placas madres gaming vienen con botones de «auto-OC» que en unos clics suben un pelín las frecuencias si es que pueden, pero francamente la mayoría ni lo usa. Las discusiones en foros viraron: en vez de «¿cómo overclockeo mi 6600K?», ahora se ve más «¿conviene desactivar undervolt protection?» o «¿cómo configuro la curva de ventiladores?». El énfasis pasó de exprimir más FPS a mantener estabilidad y temperaturas a raya. Porque, paradójicamente, como los CPUs ya andan al límite, el entusiasta actual se preocupa más por bajar calor y ruido que por subir clocks. Un cambio de paradigma total.

Culturalmente, hay cierta nostalgia flotando en el aire. Los veteranos extrañamos esa edad del bronce del hardware, donde cada componente tenía un «potencial oculto» y descubrirlo era motivo de orgullo. Hoy un Core i7 13700KF lo sacás de la caja, le pones buen cooling, y sí, capaz le subís 100-200 MHz manualmente sacrificando 50W extra… pero en el fondo sabés que el rendimiento no va a cambiar tu experiencia de uso. Antes podías obtener auténticas mejoras del 20-50% y cambiar de categoría de producto; ahora quizás rasguñas un 5% que en bench se ve pero en la vida real meh.

Hasta las comunidades refuerzan esta idea. Un veterano del foro Overclockers UK resumía en 2025: «Con los CPUs llegando casi muertos de fábrica en cuanto a clocks, el overclocking está tan bueno como muerto. ¿Para qué tirar voltaje a un CPU/GPU por un par de FPS extra y muchísimo más calor y consumo? Hoy la onda es undervoltear: menos voltaje, menos calor, y así el chip mantiene los boost altos por más tiempo.». Otro respondía lapidario: «El undervolt es el nuevo overclock.». Ironías de la vida: lo que antes veíamos como contraproducente (bajar voltaje) ahora es sello de entusiasta inteligente, porque mejora la eficiencia sin perder rendimiento.

En cuanto al sentimiento, para muchos entusiastas veteranos esto es agridulce. Por un lado, se perdió la diversión de «romper límites». Armás un PC gamer hoy y prácticamente no tenés nada que tunearle manualmente para que rinda más: viene todo ya optimizado. El hobby del overclock mutó a otras cosas: case-modding, custom loops de refrigeración líquida, tweaking de periféricos, o directamente a jugar más que a toquetear la máquina. Las míticas competencias de 3DMark con colegas dieron paso a… comparativas de puntajes de Cinebench stock, donde gana el que pagó el modelo más caro, básicamente. Un poco se apagó ese fuego romántico del geek hardware que quiere hacer magia con poco recurso.

Por otro lado, hay quienes celebran el cambio: el usuario promedio gana en estabilidad y simplicidad. Ya no tenés que ser ingeniero para obtener buen rendimiento. Un pibe que compra una PC gamer decente hoy obtiene automáticamente la mejor versión de su hardware sin arriesgar nada, más que asegurarse de tener un buen disipador. No hay pantallas azules por OC mal hecho, no hay que andar editando el registro para fixear un Windows inestable por exceso de FSB. En definitiva, la experiencia es más plug & play que nunca en el mundo PC de alto rendimiento.

¿Bueno o malo para el usuario moderno?

Evaluemos los pros y contras de este final (o transformación) del overclock tradicional.

Ventajas (lo bueno):

- Rendimiento out-of-the-box óptimo: El usuario obtiene desde el primer día casi todo el rendimiento posible de su CPU/GPU. No necesita «conocimientos especiales» para que su Core i5 o Ryzen 7 rindan bien. Esto democratiza la potencia: antes solo el que oceaba sacaba el 100% de su hardware; hoy cualquiera lo tiene asegurado.

- Mejor rendimiento por watt y termal: Los fabricantes se volvieron expertos en balancear voltaje y frecuencia chip por chip. Un Ryzen 7000, por ejemplo, opera en una curva muy afinada gracias a sensores internos e incluso a factory tuning con técnicas de aprendizaje. Esto significa que no hay grandes excesos: si tu CPU puede hacer 5 GHz a 1.2 V, no usará 1.3 V. En los viejos tiempos, a veces Intel/AMD por seguridad te ponían voltajes de más y la comunidad descubría que podía bajarse (undervolt manual) para reducir calor. Hoy ya vienen muy cerca del óptimo. Resultado: PCs más frescas y estables en stock. Un overclock manual muchas veces implicaba meter +0.1 o +0.2 V, elevando exponencialmente el consumo/temperatura por la ley cuadrática del voltaje, para ganar 2-5% de clock. Ya no es necesario ese trade-off para la mayoría.

- Estabilidad y longevidad: Usar componentes sin forzarlos más allá de espec lo agradecen todos: menos riesgo de dañar el hardware y probablemente mayor vida útil sin degradación. Un CPU moderno usado stock (o con undervolt) quizás dure 10+ años funcionando, algo impensado si lo usabas con +30% voltaje constante antes. Además, sin OC extremo, las motherboards y fuentes también sufren menos estrés. Para el usuario común, esto se traduce en menos fallas aleatorias y menos crashes inexplicables. Las garantías tampoco se ven comprometidas; muchas marcas te niegan RMA si el chip tiene signos de overclock excesivo. Ahora eso es casi anecdótico.

- Experiencia simplificada: Antes, sacarle jugo a un tope de gama requería saber toquetear en BIOS (ej: habilitar XMP para que la RAM corra a su velocidad, ajustar PBO, etc.). Hoy hasta eso es automático: las memorias DDR5 con XMP/EXPO traen perfiles listos que configuras con un clic y ya estás «overclockeando» la RAM sin saber de CAS Latency ni voltajes. Lo que antes era una tarde ajustando timings, hoy es cargar el perfil DDR5-6000 de fábrica y listo. Lo mismo con GPUs: aplicaciones de los fabricantes ajustan fan curves o hacen OC ligero automático con seguridad. En síntesis, menos headaches, más tiempo para disfrutar.

Desventajas (lo malo / lo que se pierde):

- Adiós a la «diversión gratis»: Se acabó ese placer de comprar un micro barato y convertirlo en un Ferrari. Hoy si quieres rendimiento superior, casi seguro debas pagar por el modelo superior y no hay atajo mágico. Por ejemplo, si quieres más que un Ryzen 7600, tendrás que comprar un 7700 o 7800X3D; no es tan viable hacer que el 7600 alcance al 7700 con OC porque ya viene al límite. Para entusiastas con presupuesto acotado, el overclock era un salvavidas (tener rendimiento alto sin gastar tanto). Esa posibilidad se redujo mucho, salvo contadas excepciones.

- Menos libertad y tinkering: A muchos nos encantaba la experimentación en sí misma. Aunque no «necesitáramos» el OC, lo hacíamos por el desafío intelectual y el orgullo nerd. Era una forma de personalizar y dominar tu máquina. Hoy gran parte de esa libertad se sacrifica en pos de la optimización de fábrica. Para algunos esto hace a las PCs más aburridas, más cerradas como los dispositivos Apple donde prácticamente no puedes meter mano. Un entusiasta actual puede sentirse encorsetado: solo puede ajustar curvas de ventilador, hacer undervolt, o quizás overclockear un poquito la GPU sabiendo que ganará 3-5%. Ya no hay ese gran lienzo en blanco para pintar a gusto.

- Menos comunidad e innovación desde el usuario: En el pasado, muchas mejoras venían de la comunidad entusiasta empujando límites, y los fabricantes aprendían de eso. Ejemplo: el desarrollo de mejores coolers, fuentes, BIOS más flexibles, etc., fue impulsado por demanda de overclockers. Al decaer el OC, tal vez se innova menos en ciertos rubros. Las motherboards gama alta aún incluyen mil opciones de OC, pero son overkill que pocos usan. Podríamos decir que el hobby se volvió más consumista (comprar el mejor componente posible) y menos maker (mejorar uno mismo lo que tiene). Para los que ven la PC como algo más que un electrodoméstico, esto es un cambio cultural importante.

- El factor emocional: Puede sonar tonto, pero el overclocking tenía un componente emocional potente. Era casi una filosofía de vida para algunos: «si puedo mejorarlo, ¿por qué dejarlo estándar?». Quitar eso deja un vacío. El usuario moderno quizás ni lo note, pero el veterano siente que falta ese romanticismo DIY. Es la diferencia entre armar un auto de carreras en tu garaje vs. comprarte uno ya tuneado de agencia. Sí, el de agencia anda perfecto, pero el que armaste vos tiene tu alma en cada tornillo. Esa conexión emocional máquina-usuario se ha diluido.

GPUs, memorias y placas madre: todo sigue la misma tendencia

No solo las CPUs vivieron este cambio. En otros componentes del PC se observa la misma «muerte del OC manual»:

- Tarjetas gráficas (GPUs): Hoy las GPUs vienen con algoritmos tipo NVIDIA GPU Boost o el AMD Boost equivalente que automágicamente elevan la frecuencia de núcleo mientras haya margen térmico/energético. Una RTX moderna, por ejemplo, quizás tenga un reloj base de 1500 MHz pero en la práctica corre a 1900-2000 MHz de fábrica gracias al auto-boost. El margen para overclock manual suele ser muy pequeño, a veces un +5% extra subiendo power limit y jugando con curvas, y a costa de mucho más consumo. De hecho, es más común undervoltear la GPU para que mantenga clocks altos con menos voltaje, reduciendo 50 W de consumo sin perder rendimiento, que intentar llevarla 50 MHz más arriba. Los fabricantes además limitan vía BIOS cuánto puedes subir: los «power limit» están bloqueados a cierto % y romper eso requiere flashear BIOS especiales, algo que pocos se atreven. Resultado: las GPUs ya no se overclockean casi de forma tradicional, sino que se optimizan para mejor noise/heat. Incluso hay polémica con que muchos modelos partner vienen ya tan al límite que overclockear manualmente en realidad disminuye el rendimiento porque genera throttling antes.

- Memorias RAM: Como mencionamos, la introducción de XMP (Intel) y EXPO (AMD) convirtió el overclock de RAM en un simple perfil preconfigurado. En DDR5 esto es clarísimo: uno compra, digamos, un kit DDR5-6000 CL30, y ese kit ya es técnicamente un overclock sobre el estándar JEDEC DDR5-4800. Pero el fabricante lo probó, lo programó en el módulo, y vos solo lo cargas y listo – ya obtienes ese rendimiento «OC» garantizado. Antes tenías que cruzar dedos mezclando BIOS settings de frecuencia, latencias primarias, secundarias, voltaje DRAM, controlador de memoria… ahora la mayoría de usuarios ni entra en esos detalles. Solo los overclockers de RAM extremos siguen tweakeando manual más allá de XMP (ej: llevándolas de 6000 a 6400 y ajustando timings a mano) pero son pocos. Para colmo, los beneficios en la vida real de exprimir memorias ya son bastante marginales (salvo en ciertos benchmarks o cargas muy específicas).

- Motherboards: Las placas madres de los 90/2000 venían con DIP switches, jumpers, BIOS ocultos (secret menus tipo modo jumperfree) y requerían cierto conocimiento para exprimir. Había modelos casi hechos para overclock: por ejemplo, la ABIT BP6 famosa por soportar dos Celeron (dual socket) y permitir subirles el bus; o las DFI LanParty NF4 que tenían voltajes insanos para RAM pensados para usarse con refrigeración activa. Hoy, la mayoría de esas «herramientas» se esconden o simplemente no existen en placas mainstream. Solo las placas high-end Z790, X670E, etc., mantienen opciones avanzadas de OC – pero ¿quién las utiliza al 100%? La mayor parte de usuarios se contenta con habilitar PBO en automático y XMP, y ni mira las otras 50 opciones de tweaking que trae la BIOS. Incluso muchas placas de gama media bloquean por chipset el OC (ej: una B660 de Intel no permite OC del multiplicador, solo las Z690/Z790 lo hacen). Antes casi cualquier placa decente permitía jugar aunque sea con el FSB. La «tuneabilidad» del sistema disminuyó, a tal punto que motherboards que antes justificaban su precio por el potencial de OC hoy lo hacen por otras razones (más puertos USB, mejor audio, RGB, etc.), porque el usuario promedio ya no valora el VRM robusto para meter 1.5 V al CPU – total nunca lo hará.

En resumen, todo el ecosistema se movió hacia entregar rendimiento garantizado y seguro, en detrimento de la libertad de overclock. Hasta en laptops gaming vemos esto: vienen con modo turbo de fábrica y no hay mucho más que exprimir, al contrario, muchos terminan undervolteando para que no se achicharre el pobre equipo.

¿El overclock murió o solo evolucionó?

El veredicto: el overclocking como lo conocíamos está efectivamente muerto para el mainstream, pero tal vez ha mutado en distintas formas en nichos específicos.

Para el 99% de usuarios, la era de «subir MHz manualmente» terminó. Obtenemos CPUs y GPUs que ya corren a todo lo que pueden, y el énfasis pasó a optimizar eficiencia. El overclock tradicional quedó relegado a un hobby de unos pocos entusiastas extremos que compiten en HWBOT con nitrógeno líquido, como un deporte electrónico/técnico. Es decir, el overclock sigue vivo solo como disciplina de récords, comparable a poner un auto de carrera en la pista sabiendo que no es para uso diario. Ahí aún hay acción: se siguen batiendo marcas mundiales (5, 6, 7 GHz… ya rompieron los 8 GHz con ciertas CPUs en laboratorio). Pero es un mundo aparte, quizá más cercano a la ingeniería eléctrica que al PC building cotidiano.

Mientras tanto, para el entusiasta de todos los días, la práctica evolucionó hacia lo que muchos llaman «fine tuning». Esto incluye: undervolt (ajustar voltajes mínimos estables para reducir consumo/calor), curve optimizer en Ryzen (que es básicamente un OC negativo por núcleo para ganar eficiencia), ajustar límites de potencia en GPUs para lograr mejor perf/watt, calibrar bien el boost dependiendo de la refrigeración (ej: hay quienes sub-relojean un poco sus CPUs a cambio de 20°C menos, preferible para usos 24/7). Incluso se podría decir que la optimización reemplazó a la maximización: antes íbamos por la máxima frecuencia a cualquier costo, ahora vamos por la mejor relación rendimiento/consumo que es un juego más complejo pero interesante. A su manera, eso también es exprimir el hardware, solo que en otra dirección.

Quedan algunos nichos donde el overclock manual aún tiene sentido. Por ejemplo, en equipos antiguos o retro, donde sí podés jugar con jumpers y multiplicadores para revivir un Pentium 4 o un Core 2 Quad sacándole extra gratis (los nostálgicos lo hacemos por deporte). O en ciertas APUs/GPUs integradas de gama baja, donde un OC a la iGPU puede sumar fps valiosos en juegos si estás dispuesto a afinarlo (aunque con riesgo). Pero en hardware moderno de gama media/alta, honestamente, no hay mucho que rascar.

¿Es esto bueno o malo? Como vimos, tiene sus dos caras. Para el consumidor masivo es genial tener poder sin esfuerzo. Para la cultura entusiasta, se pierde un poco el alma DIY. Tal vez estemos presenciando una metamorfosis: el espíritu de «romper límites» sigue presente pero se canaliza distinto. Los modders ahora desafían límites de construcción (PCs en formato mini ITX súper potentes, loops custom artísticos, overclock de monitores, etc.). Y los tweakers persiguen el santo grial de la eficiencia, que en tiempos de conciencia energética no es poca cosa – exprimir más trabajo por watt es el nuevo campo de batalla, tanto o más retador que exprimir MHz.

En definitiva, 2025 marcó el fin de una era romántica en la que cualquiera con paciencia y curiosidad podía hacer magia con su PC. El overclocking, tal como lo conocimos en los 90s y 2000s, ha muerto o quedado reservado a unos pocos. Pero de sus cenizas nacieron nuevas formas de entusiasmo hardware. Quizá ya no «overclockeamos» en el sentido clásico, pero seguimos buscando cómo sacar lo mejor de nuestras máquinas, ya sea afinando el voltaje, mejorando la refrigeración o simplemente entendiendo las complejas decisiones que nuestros chips toman solos.

Como buen geek de la vieja escuela, da un poco de nostalgia decirlo: se cierra un capítulo. Aquel ritual de subir el FSB y reiniciar cien veces hasta lograr estabilidad a 300 MHz extra, quedó para los libros de historia (o los hilos de Reddit llenos de anécdotas). Nos queda brindar por esos días gloriosos de OC con olor a estaño quemado, y aceptar que hoy las batallas se libran en otros frentes. Al final, la pasión por el hardware perdura – solo cambió de forma. Y quién sabe, quizás en el futuro vuelva a presentarse alguna revolución tecnológica que nos devuelva el overclock como lo conocíamos. Mientras tanto, RIP overclocking tradicional (1995-2025). Fue hermoso mientras duró.